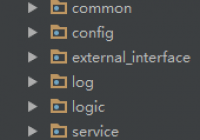

在开发项目时,要预先设定好项目结构,比如下面就是一个常用的项目结构。

一、配置目录

由于这个项目比较简单,所以不用创建那么多分类,只需要api、common、config、log和test五个目录就可以了。

在项目文件中,分别创建api、common、config、log和test五个目录。

二、将const.py文件放到config文件夹。

const.py是一……

在开发项目时,要预先设定好项目结构,比如下面就是一个常用的项目结构。

一、配置目录

由于这个项目比较简单,所以不用创建那么多分类,只需要api、common、config、log和test五个目录就可以了。

在项目文件中,分别创建api、common、config、log和test五个目录。

二、将const.py文件放到config文件夹。

const.py是一……

互联网

关于互联网上七大姑,八大姨的一些九卦。

0

一天学会Python Web框架(二)

0

一天学会Python Web框架(一)

0

关键字提取工具

0

Python 操作MySQL数据库(Mysql备忘)

0

关闭wordpress上传自动生成缩略图功能

0

暴力破解wordpress密码

0

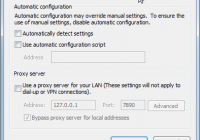

Python requests.exceptions.ProxyError的解决办法

0

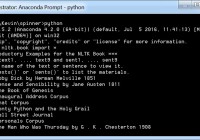

nltk book

0

NLP的构想

0